引言

在与大语言模型(LLM)的交互过程中,我们经常能体验到一种独特的"逐字输出"效果,就像是与一位真实的对话者进行实时交流。这种设计不仅让交互体验更加自然,还有效缓解了用户在等待长文本生成时的焦虑感。

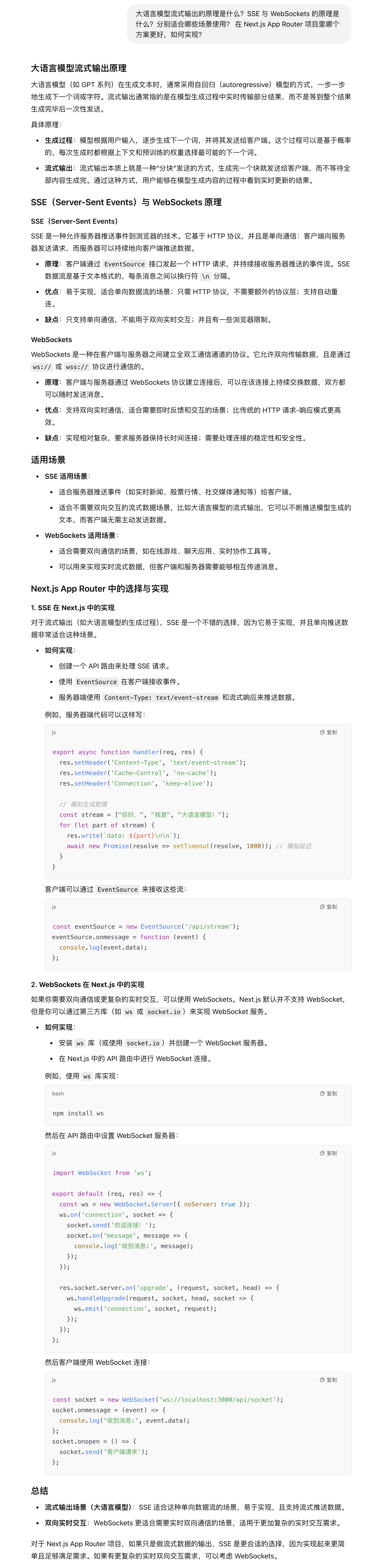

我一直对这种"逐字输出"背后的技术实现充满好奇,这背后具体的原理是什么,在项目里要怎么实现这个效果?今天,我就这个问题向 ChatGPT 提问,看看它能给我什么答案。

对话内容

小记

-

流式输出的本质: 大语言模型的文本生成过程采用了流式处理机制,类似于"水流"般持续输出。模型不是一次性生成所有内容,而是将文本分成多个小片段,按照生成顺序逐步推送。这种机制让用户能够实时看到生成过程,大大提升了交互体验。

-

SSE 与 WebSockets 的技术对比: SSE (Server-Sent Events) 好比一条单向高速公路,专门用于服务器向客户端推送数据,结构简单且资源消耗低。相比之下,WebSockets 则像一座双向立交桥,支持服务器和客户端之间的实时双向通信。在单纯的文本流式输出场景下,SSE 的轻量级特性使其成为更优的选择。

-

Next.js App Router 的最佳实践: 在 Next.js App Router 框架中,SSE 的实现方式与框架的设计理念高度契合。Next.js 提供了完善的 API 支持,使得流式输出的实现变得简单直接。这种技术方案不仅开发成本低,而且能够提供更好的性能表现。

-

OpenAI API 的流式集成: OpenAI 的 API 已经内置了完善的流式输出支持。通过简单的配置(设置 stream: true),API 就能自动按序列推送文本片段。开发者只需要在 Next.js 中编写相应的接收和展示逻辑,就能实现流畅的逐字输出效果。